In het tweede deel van onze blogserie, Naleving van de AI Act Deel 2: Wat is een activiteit met een ‘hoog risico’? verkennen we de risicogebaseerde benadering van de AI Act van de classificatie van AI-systemen. Welke toepassingen zijn verboden, wat is een activiteit met een ‘hoog risico’ en welke systemen zijn vrijgesteld?

In onze blogserie ‘Naleving van de AI Act’ verkennen we wat u moet weten over de wettelijke verplichting bij het inzetten van bepaalde kunstmatige intelligentie (artificial intelligence, of AI)-technologieën onder de toonaangevende AI Act van de EU.

Voor meer informatie over de tijdlijn van de AI Act en de deadlines van het schema voor gefaseerde implementatie, verwijzen we u naar Deel 1 van onze blogserie – Naleving van de AI Act Deel 1: Tijdlijn en belangrijke deadlines

De risicogebaseerde classificatie van AI-systemen

De AI Act hanteert een risicogebaseerde aanpak bij de classificatie van AI-systemen. De wet streeft ernaar een evenwicht te vinden tussen innovatie en regulatie om aantasting van de gezondheid, veiligheid en de fundamentele mensenrechten te voorkomen. Door het risico te beoordelen, erkent de wetgeving dat niet alle AI-systemen hetzelfde niveau van dreiging vormen en dat verschillende niveaus van controle en overzicht vereist zijn.

AI-systemen worden gecategoriseerd in verschillende risiconiveaus op basis van de potentiële impact, waarbij de last van de compliance toeneemt in verhouding met het risico.

Dit zijn de drie belangrijkste categorieën:

- Verboden

- Hoog risico

- Laag risico

Verboden systemen

De AI-toepassingen die in deze categorie vallen, zijn volledig verboden vanwege potentiële onacceptabele negatieve gevolgen.

Systemen met een hoog risico

Deze systemen hebben een significante impact op de veiligheid, het welzijn en de rechten van mensen, en zijn daarom toegestaan, maar wel onderworpen aan strengere eisen.

Systemen met een laag risico

Deze systemen brengen minimale gevaren met zich mee, waardoor ze aan minder compliance-verplichtingen hoeven te voldoen.

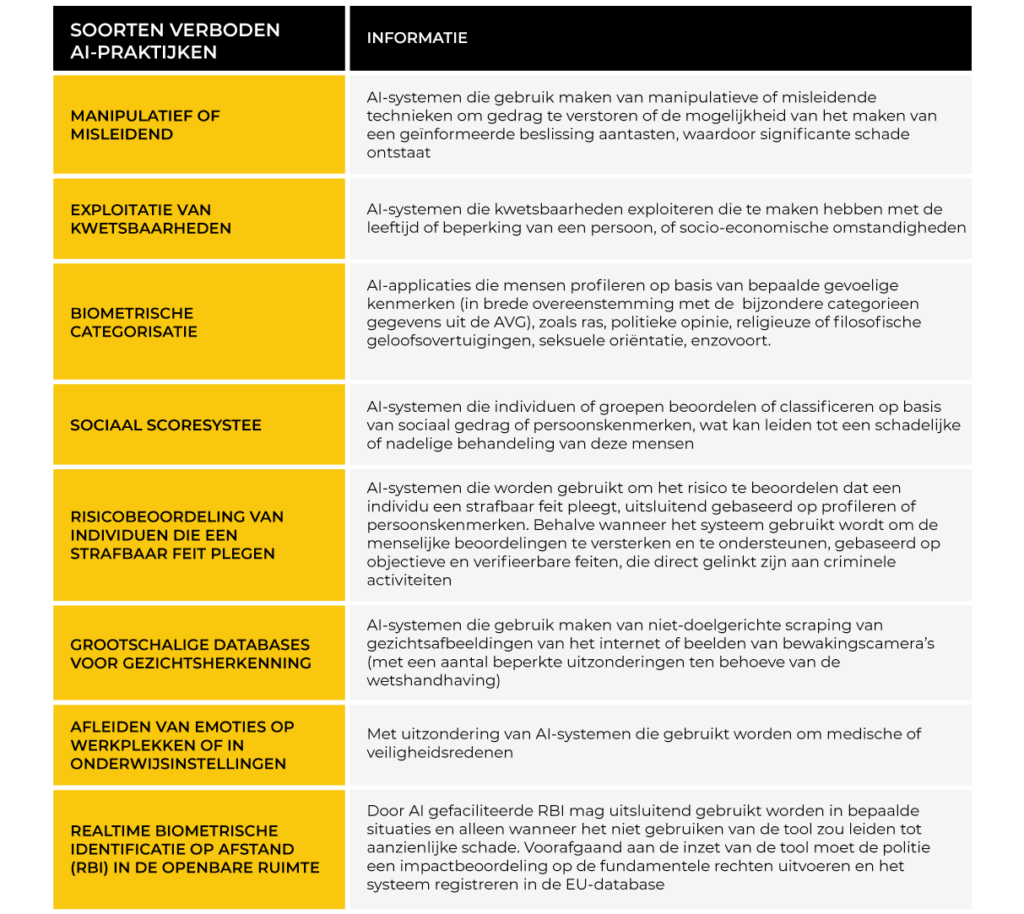

Verboden AI-toepassingen onder de AI Act

Het verbod op onaanvaardbare risico’s met betrekking tot AI-systemen treedt 6 maanden na publicatie van de AI Act in het officiële Publicatieblad van de EU in werking (bekijk de tijdlijn van het schema van gefaseerde implementatie hier).

De Europese Commissie zal de lijst met verboden AI-toepassingen regelmatig herzien, met de eerste herziening 12 maanden nadat de AI Act in werking is getreden.

In de tabel hieronder staan de typen AI-praktijken die in de categorie verboden vallen. Dit zijn technieken en benaderingen met onaanvaardbare risico’s voor de gezondheid en veiligheid of de fundamentele mensenrechten:

Wat is een activiteit met een ‘hoog risico’?

Het merendeel van de AI Act gaat over de regulatie van AI-systemen met een hoog risico en deze systemen worden onderverdeeld in drie afzonderlijke categorieën:

- Wanneer het AI-systeem zelf een bepaald soort product is

- Wanneer het AI-systeem een beveiligingscomponent is van een bepaald soort product

- Wanneer het AI-systeem voldoet aan de omschrijving van een vastgestelde lijst van systemen met een ‘hoog risico’

Laten we deze categorieën met een hoog risico eens nader bekijken:

Wanneer het AI-systeem zelf een bepaald soort product is

Dit verwijst naar AI-systemen die niet een component of functie zijn van een groter product, maar zelf het volledige product uitmaken. Veel van dit soort producten worden al gereguleerd door bepaalde EU-harmonisatiewetten. Voorbeelden zijn medische apparaten, machines uit de zware industrie, auto’s en speelgoed. Deze worden genoemd in Bijlage I van de AI Act.

Als u een AI-systeem ontwikkelt of inzet in een sector met een strenge veiligheidswetgeving, is er een grote kans dat het systeem hieronder valt, en moet u genoem de bijlage volledig doornemen.

Aangezien deze producten al onderworpen zijn aan strenge veiligheidsmaatregelen, worden ze automatisch beschouwd als behorend tot de categorie ‘hoog risico’ onder de AI Act.

Wanneer het AI-systeem een beveiligingscomponent is van een bepaald soort product

Dit betekent dat het AI-systeem geen op zichzelf staand product is, maar binnen een product veiligheidsgerelateerde functies uitvoert. Bijvoorbeeld, wanneer een AI-systeem gebruikt wordt voor monitoring, controles of het beheren van veiligheidsfuncties.

Veel van deze systemen zijn al gerelateerd aan producten die in Bijlage I van de AI Act voorkomen, zoals industriële machinerie, liften, medische apparaten, motorvoertuigen, enzovoort.

Wanneer het AI-systeem voldoet aan de beschrijving van een vastgestelde lijst van systemen met een ‘hoog risico’

Er zijn bepaalde AI-systemen die niet in Bijlage I genoemd worden, maar die ook als een hoog risico worden beschouwd.

Deze gedefinieerde lijst omvat systemen die een significante impact zouden hebben op eventuele gelijke kansen van mensen en die mogelijk structurele vooroordelen tegen bepaalde groepen zouden kunnen veroorzaken.

Deze systemen vallen in 8 brede gebieden:

- Biometrie

Bepaalde biometrische verwerking is volledig verboden, zoals hierboven uitgelegd, maar alle andere verwerking van biometrische gegevens is geclassificeerd als hoog risico (met de uitzondering van ID-verificatie van een individu voor cybersecuritydoeleinden, zoals bijvoorbeeld Windows Hello)

- Kritische infrastructuur

AI-systemen die worden gebruikt als beveiligingscomponenten in het beheren van de kritische digitale infrastructuur (gelijk aan de lijst in Bijlage I) en AI-systemen die gebruikt worden voor de toevoer van water, gas of elektriciteit

- Onderwijs

Elk AI-systeem dat aanmeldingen of leerresultaten beoordeelt zijn hoog risico, vanwege de potentiële impact op iemands leven, dat wil zeggen het risico op het voortzetten van historische discriminatie van vrouwen en etnische minderheden

- Werkgelegenheid en management

Elk AI-systeem dat wordt gebruikt voor de werving, analyse van een sollicitatie en beoordeling van een kandidaat wordt beschouwd als hoog risico. Ook besluitvormende AI-tools die gebruikt worden voor het monitoren van de prestaties, werkrelaties of het beëindigen van een arbeidscontract zijn een hoog risico

- Toegang tot essentiële diensten

Systemen die de toegang bepalen tot essentiële diensten zoals sociale voorzieningen als een werkeloosheids- of arbeidsongeschiktheidsuitkering, en de gezondheidszorg, of particuliere voorzieningen zoals systemen voor kredietscores

- Wetshandhaving

Bepaalde taken worden beschouwd als hoog risico, waaronder het gebruik van leugendetectors of gelijkwaardige biometrische tools die gebruikt worden voor het beoordelen van een getuigenverklaring, en systemen die gebruikt worden voor het beoordelen van de kans van een individu op recidive

- Immigratie

Systemen die worden gebruikt om het veiligheidsrisico te beoordelen van migranten die de EU binnenkomen, of voor het verwerken en beoordelen van asielaanvragen. AI-systemen die worden gebruikt voor het verifiëren van identiteitsdocumenten vormen hierop een uitzondering

- Administratie van juridische en democratische processen

Dit omvat AI-systemen die worden gebruikt bij juridisch onderzoek of het interpreteren van de wet, zoals juridische databases die worden gebruikt door advocaten en rechters. Ook systemen die invloed kunnen hebben op een verkiezing, zoals die welke gebruikt worden voor gerichte politieke advertenties

Uitzonderingen voor verboden en hoog-risico AI-systemen

Bepaalde AI-systemen die anderszins beschouwd kunnen worden als hoog risico of verboden, zijn uitgezonderd van de AI Act.

Uitzonderingen voor verboden systemen komen met name voor ten behoeve van onderzoek en de nationale veiligheid.

Uitzonderingen voor systemen met een hoog risico vallen voornamelijk onder deze criteria:

- De AI voert enkel een beperkte, procedurele taak uit

- De AI verbetert het resultaat van een activiteit die voorheen door een mens werd uitgevoerd

- De AI is bedoeld om vooroordelen of andere patronen in het maken van besluiten te detecteren en te monitoren, en is geen vervanging voor het nemen van besluiten door mensen en is onderworpen aan menselijke beoordeling

- De AI wordt gebruikt voor een voorbereidende taak die relevant is voor de beoordeling van een taak die anders hoog risico zou zijn, dat wil zeggen, AI kan gebruikt worden om te helpen bij de beoordeling van een use case

Wat betekent dit voor organisaties die gebruik maken van AI-systemen met een hoog risico?

AI-systemen met een hoog risico vereisen een grondige risico- en veiligheidsbeoordeling en een EU-registratie en evaluatie door een derde partij kunnen vereist zijn. Er zijn ook aanzienlijke transparantieverplichtingen en gebruikers moeten duidelijk geïnformeerd worden over hoe het AI-systeem wordt ingezet en hoe het functioneert.

Als u hulp of advies nodig heeft voor de noodzakelijke stappen voor het veilig uitrollen van uw AI-systeem op een manier die in overeenstemming is met de vereisten van de AI Act van de EU, neem dan contact op met ons gespecialiseerde team van Functionarissen Gegevensbescherming.

In het volgende deel…

In het volgende deel van onze blogserie gaan we dieper in op de verplichtingen van de AI Act, en bespreken we op wie de AI Act van toepassing is en wat de vereisten zijn.

Hou ons in de gaten voor: Naleving van de AI Act Deel 3: Op wie is de AI Act van toepassing en wat zijn uw plichten?

Volg The DPO Centre op LinkedIn voor meer nieuws over en inzicht in gegevensbescherming